Google AI は、画像の言語理解モデル『Locked-Image Tuning: Adding Language Understanding to Image Models』を公式ブログで発表しました。

これまで BERT や MUM を用いてコンテンツにおける言語理解を学習し、検索エンジンにも大きな影響を与えてきましたが、ついに画像の言語理解も進化させてきました。

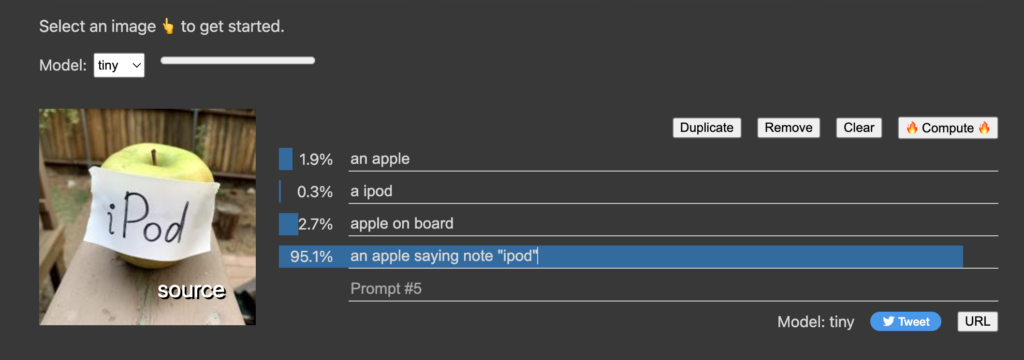

実際にLiT(Locked-Image Tuning: Adding Language Understanding to Image Models)のインタラクティブデモを操作して、画像に対し「an apple」「a ipod」「an apple saying note “ipod”」と入力してみました。

正直、精度にビビります(笑)

この記事では、この強力な言語理解モデルLit(Locked-Image Tuning: Adding Language Understanding to Image Models)を紹介しますね。

事前学習や対照学習によって画像をカテゴリー分類するには限界がある

Google AI ブログは言語理解のディープラーニングについて以下のように記述しています。

It has also been significantly accelerated by transfer learning, whereby models are first pre-trained on large datasets, like ImageNet, to learn visual representations that are then transferred via fine-tuning to a new task with less data (e.g., classifying animals).

画像に言語理解を追加する初期学習モデルとして、データセットモデルで事前学習してから視覚表現を学習した後に「動物の分類」のようなカテゴリーに分類していたよう。

ただし、データセットによる事前学習は1度のみでありタスクごとに新しいデータセットを用意する必要があることに難点があったようです。

However, fine-tuning has some downsides: though pre-training is done only once, fine-tuning is necessary on every new dataset for which task-specific data is needed.

次に、データセットを備える方式に対して「マルチモーダル対照学習」として『自由テキスト × 画像』のマッチング方式を利用することでデータセットの問題は解決。

Multimodal contrastive learning is an alternative, recently popularized paradigm (e.g., CLIP, ALIGN) that overcomes these issues by instead learning how to match free-form text with images.

ところが、自由テキストの場合は『テキスト×画像』のバリエーションが多く、データセットによる事前学習に比べて精度が劣るというデメリットがあったようです。

Contrastive learning is flexible and easy to adapt to new tasks, but has its own limitations, namely the need for a lot of paired image-text data and weaker performance than transfer learning approaches.

学習済みの画像エンコーダーにテキストをマッチングするように学習させる『 LiT :Locked-Image Tuning: Adding Language Understanding to Image Models 』

事前学習や対照学習の問題点を解決するために、Google AI では新しい学習モデルを利用する予定です。

With those limitations in mind, we propose “LiT: Zero-Shot Transfer with Locked-image Text Tuning”, to appear at CVPR 2022. LiT models learn to match text to an already pre-trained image encoder.

事前学習はバリエーションが少ないぶん精度が高い、一方でマルチモーダル対照学習(ゼロショット学習)はバリエーションが豊富なぶん精度が劣る。

そこで、事前に学習された画像エンコーダから得られる表現とよく一致する表現をテキストモデルで計算して対比的に学習させるのが「LiT: Locked-Image Tuning: Adding Language Understanding to Image Models」。

LiT は、事前学習した画像エンコーダをロックした状態でテキストエンコーダが計算することで、ロックされた画像エンコーダと自由テキストをマッチングさせて高速学習させる『Zero-Shot Transfer with Locked-image Text Tuning』システム。

2,400万組の一般公開された画像とテキストのペアで学習したLiTモデルは、なんと4億組のプライベートデータで学習した先行モデルのゼロショット分類に匹敵するようです。

LiT models trained on 24M publicly available image-text pairs rival the zero-shot classification performance of prior models trained on 400M image-text pairs of private data.

「LiT: Locked-Image Tuning: Adding Language Understanding to Image Models」により、画像の言語理解がより正確になることが予想されます。

このことを考えるとコンテンツ内で使用する画像は「単なる装飾目的」ではなく、コンテンツと関わる「意味のある画像」を利用する必要があるのではないかと思いますね。

ぜひ、あなたもインタラクディブデモを試してみてくださいね!

コメント